헬창 개발자

논문 리뷰: DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning 본문

논문 리뷰: DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

찬배 2025. 2. 5. 16:23🤔들어가기전에 알고가기

1. DeepSeek-V3 개요

DeepSeek-V3는 671B(6710억) 개의 총 파라미터를 가진 Mixture-of-Experts (MoE) 기반 대규모 언어 모델이다. 하지만 한 번의 토큰 예측 시 활성화되는 파라미터는 37B로 효율성을 극대화하였다.

주요 특징:

- Multi-Head Latent Attention (MLA): 메모리 절약과 빠른 추론을 위한 새로운 주의(attention) 기법

- DeepSeekMoE with Auxiliary-Loss-Free Load Balancing: 부가적인 손실(auxiliary loss) 없이 부하 균형(load balancing)을 유지하는 새로운 MoE 아키텍처

- Multi-Token Prediction (MTP): 여러 개의 토큰을 한 번에 예측하는 훈련 목표를 설정하여 모델의 성능을 향상

1.1. 학습 과정

- 사전 학습 (Pre-Training): 14.8조 개의 고품질 데이터를 활용하여 학습

- 컨텍스트 길이 확장 (Context Length Extension): 32K → 128K로 확장

- 후처리 학습 (Post-Training): 지도 미세 조정(SFT)과 강화 학습(RL) 적용

1.2. 모델 성능

DeepSeek-V3는 여러 벤치마크에서 뛰어난 성능을 보이며, 특히 수학 및 코드 관련 평가에서 최고 수준의 성능을 기록하였다. 또한 OpenAI GPT-4o 및 Claude-3.5 Sonnet과 비교하여 경쟁력 있는 성능을 보인다.

주요 벤치마크 성능 비교:

- MMLU-Pro: 75.9점 (GPT-4o: 78.0)

- GPQA-Diamond: 59.1점 (GPT-4o: 65.0)

- MATH-500: 90.2점 (GPT-4o: 78.3)

- Codeforces: 51.6 퍼센타일 (GPT-4o: 50.8)

2. DeepSeek-R1 개요

DeepSeek-R1은 추론(reasoning) 능력을 강화하기 위한 모델로, 강화 학습(RL)을 활용하여 개발되었습니다.

2.1. 주요 특징

- DeepSeek-R1-Zero: 지도 학습(SFT) 없이 순수 강화 학습만으로 추론 능력을 발전시킨 모델

- DeepSeek-R1: 초기 지도 학습을 거친 후 강화 학습을 적용한 최종 모델

- Distillation (지식 증류): 대형 모델의 추론 능력을 1.5B~70B 크기의 작은 모델로 이전하여 작은 모델도 강력한 성능을 가질 수 있도록 함

2.2. 강화 학습 기법

- Group Relative Policy Optimization (GRPO): 기존 RLHF보다 효율적인 RL 방식 적용

- Self-Reflection & Verification: 모델이 스스로 답변을 검토하고 수정하는 능력 학습

2.3. 모델 성능

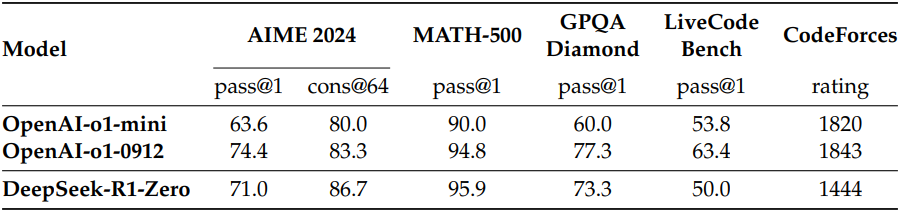

DeepSeek-R1은 OpenAI o1-1217 모델과 유사한 성능을 보이며, 특히 수학 및 코드 벤치마크에서 압도적인 성능을 기록

주요 벤치마크 성능 비교:

- AIME 2024 (Pass@1): 79.8점 (OpenAI o1-1217: 79.2)

- MATH-500: 97.3점 (OpenAI o1-1217: 96.4)

- Codeforces (Percentile): 96.3 (DeepSeek-V3: 51.6)

✅dataset

| 데이터 유형 | 목적 | 구성 방법 | 규모 | 특징 |

| Cold Start 데이터 | 초기 RL 학습 불안정성을 제거하고 초기 모델 수렴을 가속화 |

|

수천 개 |

|

| Reasoning 데이터 | 수학, 과학, 코딩 등 논리적 추론 작업의 성능 강화 |

|

약 60만 개 |

|

| Non - Reasoning 데이터 | 일반 작업(작성, 번역, 질문 응답 등)의 성능 강화 |

|

약 20만 개 |

|

| 통합 데이터 | Reasoning 및 Non-Reasoning 데이터 통합, 다양한 작업 성능 최적화 |

|

약 80만 개 |

|

✅deepseek post-training flow

🪄Introduction

최근 OpenAI의 o1 시리즈 모델이 Chain-of-Thought(CoT) 기반 추론을 확장하며 성능을 높였지만, test-time scaling 문제는 해결되지 않았음. 해 연구에서는 강화 학습(RL)만으로 LLM이 스스로 추론 능력을 향상할 수 있는지 실험을 진행하였다.

DeepSeek-R1-Zero: 순수 RL만으로 성능 개선

- DeepSeek-V3-Base 모델 + GRPO RL 프레임워크 적용

- AIME 2024 점수 15.6% → 71.0% (다수결 적용 시 86.7%)

- 하지만 가독성 저하, 언어 혼합 문제 발생

DeepSeek-R1: Cold Start 데이터 + 다단계 학습 적용

- 소량의 supervised 데이터 + RL + 추가 SFT 조합

- 최종적으로 OpenAI-o1-1217과 동급 성능 확보

Distillation: 작은 모델도 강력한 추론 능력 확보

- Qwen2.5-32B를 기반으로 distillation → RL보다 성능 우수

- Distilled 14B 모델은 기존 QwQ-32B-Preview보다 강력

- 32B & 70B 모델은 추론 벤치마크 신기록 달성

✅순수 RL로도 LLM 성능 향상 가능성 확인

✅Distillation을 통해 작은 모델도 강력한 추론 성능 확보

DeepSeek-R1-Zero: Reinforcement Learning on the Base Model

기존 연구들은 추론 능력을 향상시키기 위해 supervised 데이터에 크게 의존

하지만 데이터 수집이 오래 걸리고 비용이 높아 효율적인 방법이 필요

👉 이 연구에서는 supervised 데이터 없이 RL만으로 LLM이 스스로 학습하는 self-evolution 가능성을 탐구

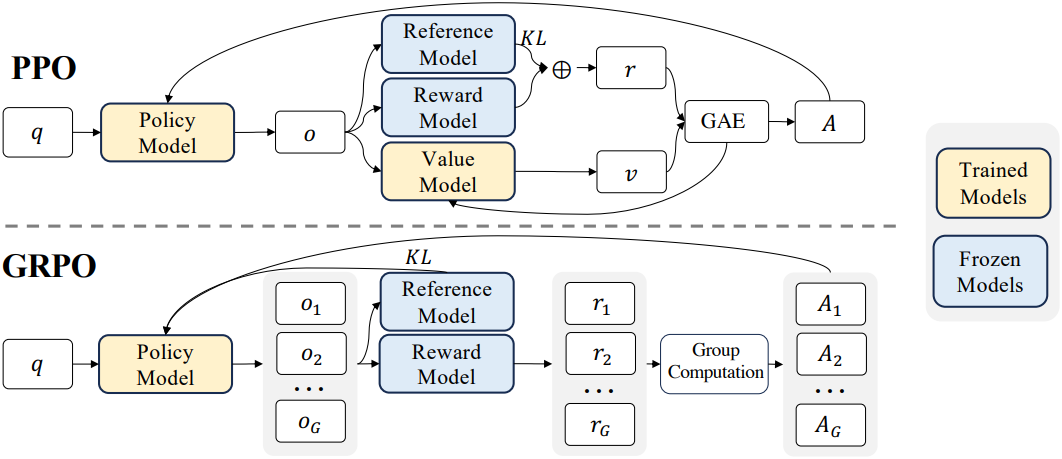

1. Reinforcement Learning Algorithm : 순수 강화 학습(RL)로 LLM의 추론 능력 향상

RL의 학습 비용을 절감하기 위해, 기존의 value 모델을 사용하지 않고

대신 Group Relative Policy Optimization (GRPO) 기법을 적용

- 일반적인 RL: policy 모델 + value 모델 → 연산 비용 높음

- GRPO 방식: value 모델 없이 그룹 점수 기반으로 기준선 추정 → 연산 비용 절감

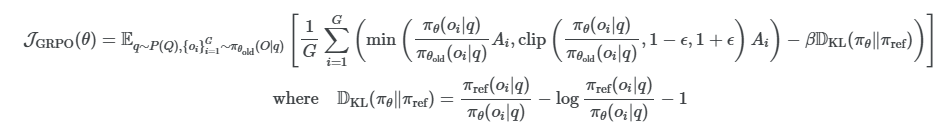

GRPO 과정

1️⃣ 각 질문 q 에 대해, 이전 policy πθold에서 출력 그룹 {oi}Gi=1 샘플링

2️⃣ 아래 목적 함수를 최대화하여 새로운 policy 모델 πθ 최적화

핵심 요소

✅ Ai: 각 출력에 대한 advantage 값, 그룹의 reward 평균을 기준으로 계산

✅ DKL: policy 모델과 기준 policy의 차이를 측정하는 KL-divergence

✅ ϵ,β: 학습을 조정하는 하이퍼파라미터

policy ratio term

새로운 정책 πθ가 주어진 출력 oi에 대해 이전 정책 πθold과 얼마나 다른지 측정

비율이 1보다 크면 새로운 정책이 해당 출력에 더 높은 확률을 할당

비율이 1보다 작으면 새로운 정책이 해당 출력에 더 낮은 확률을 할당

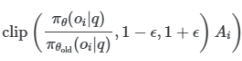

clipping term

정책이 한 번에 너무 크게 변경되지 않게 방지하는 역할

비율은 (1- ϵ , 1+ ϵ ) 범위 내로 제한하며, 모델이 단일 보상에 대해 과도하게 최적화되지 않도록 함

KL Divergence Regularizatoin

현재 정책과 기준 정책간의 차이를 측정하는 함수

만약 현재 정챡이 기준 정책과 너무 다르면 이 값은 커지고 목적 함수에 따라 패널티를 받음

이를 통해 학습이 너무 급격하게 변하지 않도록 조정

Advantage Function

각 출력 oi가 같은 그룹 내 다른 출력들과 비교했을 때 얼마나 좋은지 평가하는 방식

ri : 출력 oi의 보상

mean() : 그룹 내 보상 평균값

std() : 그룹 내 보상의 표준편차

Ai가 양수면 해당 출력(oi)가 그룹 평균보다 좋은 결과

Ai가 음수면 해당 출력(oi)가 그룹 평균보다 나쁜 결과

2. Reward Modeling : 규칙 기반 보상 시스템 적용

DeepSeek-R1-Zero를 학습시키기 위해 주로 두 가지 유형의 reward로 구성된 규칙 기반 reward 시스템을 채택함.

- Accuracy reward: 응답이 올바른지 평가하는 reward model

- Format reward: 사고 과정을 <think>와 </think> 태그 사이에 두도록 하는 reward model

Neural Reward Model을 사용하지 않은 이유

❌ Reward hacking 가능성: 강화 학습 과정에서 모델이 보상을 최적화하려다 부정확한 패턴을 학습할 위험이 있음

❌ 추가적인 학습 비용 발생: Neural reward model을 학습하려면 더 많은 리소스가 필요함

❌ 학습 파이프라인 복잡성 증가: 모델 재학습 과정이 복잡해지고, 최적의 보상 신호를 설계하기 어려워짐

3. Training Template : 규칙적인 추론 과정 유도

DeepSeek-R1-Zero를 학습시키기 위해, 저자들은 모델이 주어진 명령을 정확히 수행하도록 돕는 간단한 템플릿을 설계함

템플릿 구조

- 대화 형식:

User: 질문을 던짐

Assistant: 문제를 해결함

Assistant의 출력:

1. 사고 과정:안에 사고 과정을 먼저 생성함<think>...</think>

2. 최종 답변:안에 답변을 제공함<answer>...</answer>예시

A conversation between User and Assistant. The user asks a question, and the Assistant solves it. The assistant first thinks about the reasoning process in the mind and then provides the user with the answer. The reasoning process and answer are enclosed within <think> </think> and <answer> </answer> tags, respectively, i.e., <think> reasoning process here </think> <answer> answer here </answer>. User: prompt. Assistant:

템플릿의 목표

1️⃣ 추론 과정 생성: 모델이 먼저 사고 과정을 생각하고, 그 뒤에 최종 답을 도출함

2️⃣ 편향 최소화: 템플릿을 통해 특정 문제 해결 전략에 대한 편향을 피할 수 있음

3️⃣ 자연스러운 학습 진행: RL 과정에서 모델의 자연스러운 진행을 정확히 관찰하고 조정할 수 있음

4. Performance, Self-evolution Process and Aha Moment of DeepSeek-R1-Zero

다음은 DeepSeek-R1-Zero와 OpenAI의 o1-0912 모델을 다양한 추론 벤치마크에서 비교한 표이다.

다음은 학습이 진행됨에 따라 DeepSeek-R1-Zero의 AIME 정확도의 변화를 나타낸 그래프이다.

다음은 학습이 진행됨에 따라 DeepSeek-R1-Zero의 응답 길이의 변화를 나타낸 그래프이다.

DeepSeek-R1-Zero는 더 많은 시간동안 생각하여 추론 task를 해결하는 방법을 자연스럽게 학습함.

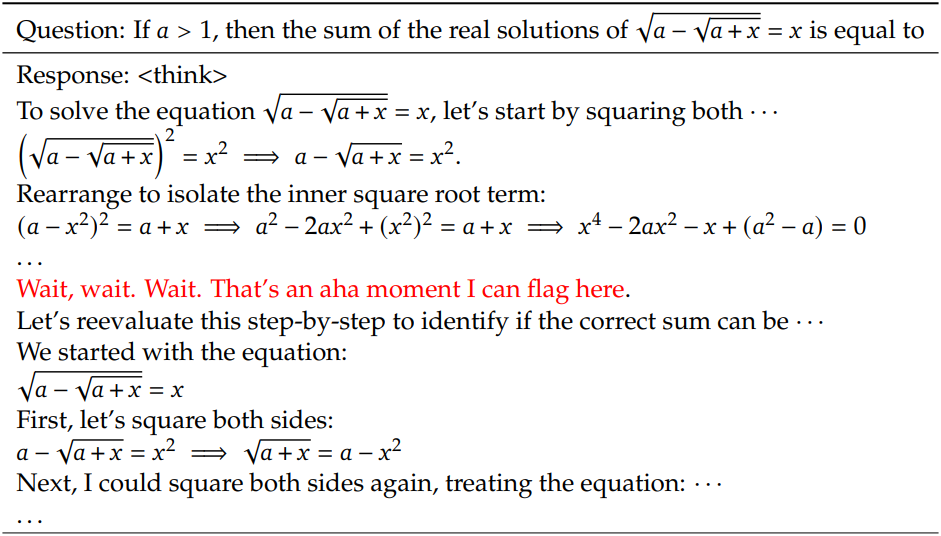

다음은 DeepSeek-R1-Zero의 중간 버전에서 나온 흥미로운 “aha moment”이다.

DeepSeek-R1-Zero는 학습이 진행될수록 추론 task 해결을 위해 더 많은 시간을 들여 생각하는 방법을 익힘.

즉, 단순히 빠르게 답을 내는 것이 아니라, 추론 과정을 길게 가져가면서 정교한 사고를 발전시키는 경향을 보임

💡 즉, 모델이 ‘더 깊이 고민하는 것이 더 나은 답을 만든다’는 개념을 학습한 순간을 발견함.

✅ 처음에는 짧고 단순한 사고 과정 → 실수 발생 확률 높음

✅ 학습이 진행될수록 추론 과정이 길어지고 정교해짐 → 정확도 향상

✅ 결과적으로 RL을 통해 모델이 논리적으로 사고하는 패턴을 스스로 습득함

DeepSeek-R1: Reinforcement Learning with Cold Start

DeepSeek-R1-Zero의 학습 과정에서 몇 가지 의문이 제기됨.

1️⃣ Cold Start 데이터를 활용하면 수렴 속도를 높이고 성능을 개선할 수 있을까?

2️⃣ 일관된 Chain-of-Thought(CoT)와 강력한 일반 능력을 가진 사용자 친화적인 모델을 만들 수 있을까?

이를 해결하기 위해 DeepSeek-R1은 4단계의 학습 파이프라인을 구축함.

1. Cold Start

DeepSeek-R1-Zero는 학습 초기에 불안정한 성능을 보였음. 이를 보완하기 위해 긴 CoT 데이터를 수집하여 DeepSeek-V3-Base를 fine-tuning함.

- Few-shot prompting을 사용하여 긴 CoT 데이터 생성

- 사람이 직접 후처리하여 가독성이 높은 데이터 구축

- 각 응답의 끝에 요약을 포함하고 사용자에게 친숙하지 않은 응답을 필터링하는 읽기 쉬운 패턴을 설계

|special_token|⟨reasoning_process⟩|special_token|⟨summary⟩ - 약 수천 개의 Cold Start 데이터로 학습 진행

💡 장점:

✅ 가독성 향상 → Markdown 형식 적용, 요약 포함

✅ 초기 수렴 속도 증가 → 더 좋은 패턴을 학습할 수 있음

2. Reasoning-oriented Reinforcement Learning

Cold Start 데이터로 fine-tuning한 후, 대규모 RL 학습을 진행함

- 코딩, 수학, 논리 추론 등 정답이 명확한 task에 집중

- RL 과정에서 CoT가 여러 언어를 혼합하는 문제 발생

→ 언어 일관성 reward 추가하여 해결

⚠️ 부작용: 언어 일관성 유지 과정에서 성능이 약간 감소했지만,

➡️ 인간의 선호도에 더 부합하고 가독성이 향상됨..

3. Rejection Sampling & Supervised Fine-Tuning (SFT)

RL이 수렴한 후, 더 다양한 도메인의 데이터를 추가하여 모델의 일반 능력을 향상함

추론 데이터:

- RL 학습 체크포인트에서 기각 샘플링(Rejection Sampling) 진행

- CoT의 가독성이 낮거나 불필요한 부분을 필터링

- 최종적으로 60만 개의 추론 관련 샘플 확보

추론과 관련 없는 데이터:

- 쓰기, 롤플레잉, 번역, QA 등 일반 task 포함

- DeepSeek-V3의 SFT 데이터 일부 재사용

- 최종적으로 20만 개의 일반 샘플 추가

➡️ 총 80만 개 데이터로 SFT 진행하여 일반 능력 강화

4. Reinforcement Learning for All Scenarios

추론 능력뿐만 아니라 모델의 유용성과 안전성도 고려한 추가 RL 학습 진행함.

추론 데이터:

- 기존 RL 방법과 동일하게 규칙 기반 reward 사용

일반 데이터:

- DeepSeek-V3 파이프라인 활용하여 유용성과 안전성 강화

- 유용성: 요약을 중심으로 평가 → 답변의 핵심 정보 전달력 향상

- 무해성: 응답의 편향, 위험 요소 제거

💡 결과:

✅ 유용성과 무해성을 개선하면서도 강력한 추론 능력 유지

Distillation: Empower Small Models with Reasoning Capability

DeepSeek-R1 수준의 추론 능력을 가진 더 효율적인 소형 모델을 만들기 위해,

저자들은 80만 개의 큐레이팅된 데이터를 활용하여 Qwen, Llama 시리즈 모델을 fine-tuning함.

Distillation 과정

- Base Model:

- Qwen2.5-Math-1.5B / 7B / 14B / 32B

- Llama-3.1-8B / Llama-3.3-70B-Instruct

- Approach:

- Supervised Fine-Tuning (SFT)만 적용 (RL 과정 제외)

- RL을 추가하면 성능이 더 향상될 가능성이 있지만,

이번 연구에서는 distillation 기술의 효과 검증이 목표였음.

Distillation 결과 & 의미

✅ 작은 모델도 DeepSeek-R1 수준의 추론 능력을 일부 계승함

✅ RL 없이도 단순한 SFT만으로 소규모 모델 성능을 크게 향상함

✅ 작은 모델도 강한 추론 능력을 가질 수 있음

👨🏫Experiment

DeepSeek-R1 Evaluation

다음은 DeepSeek-R1을 다른 모델들과 비교한 결과이다.

Distilled Model Evaluation

다음은 DeepSeek-R1에서 distillation된 모델들을 다른 모델들과 비교한 결과이다.

Distillation vs. Reinforcement Learning

다음은 추론 벤치마크들에서 distillation된 모델과 RL 모델을 비교한 결과이다.

참고자료

https://kimjy99.github.io/%EB%85%BC%EB%AC%B8%EB%A6%AC%EB%B7%B0/deepseek-r1/#introduction

https://www.youtube.com/watch?v=0WWeq97FD70&ab_channel=10XAIClub

https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf

https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf

QnA

아직 발표 안함

'공부방' 카테고리의 다른 글

| docker health check (0) | 2025.05.09 |

|---|---|

| 논문 리뷰: s1: Simple test-time scaling (1) | 2025.02.18 |

| 논문 리뷰: Phi-4 Technical Report (2) | 2025.01.15 |

| 논문 리뷰: From Local to Global: A Graph RAG Approach to Query-Focused Summarization (0) | 2024.12.23 |

| WSL 환경 localhost는 통신이 되지만, Host IP는 통신이 안되는 현상 (1) | 2024.12.18 |